Préambule : ceci est le premier article d’une série consacrée à Excel pour le SEO. Alors Stay Tuned !

Nous avons tous eu besoin un jour ou l’autre de scraper les résultats de Google, que ce soit pour un audit, un suivi de positionnement ou tout un tas d’autres choses. Il existe aujourd’hui sur le marché de très nombreuses solutions pour récupérer les résultats des pages de recherche. Je pense en premier lieu à l’excellent RDDZ Scraper, que j’utilise très souvent, mais il y en a d’autres. Le souci (mon souci) c’est que l’analyse s’effectue systématiquement sur Excel. Il faut donc exporter le résultat en CSV, l’importer dans Excel, le formater, bref …

Je vous propose en bas de cet article un document Excel que je mets à disposition gratuitement et qui va vous permettre de scraper directement dans Excel. Mais ne sautez pas les étapes et lisez bien les paragraphes ci-dessous 😉

Edit 24/09/14 – 10:15 : la version 1.5 contenait un bug, pensez à télécharger la dernière version (1.6).

J’ai besoin de quoi pour scraper directement dans Excel ?

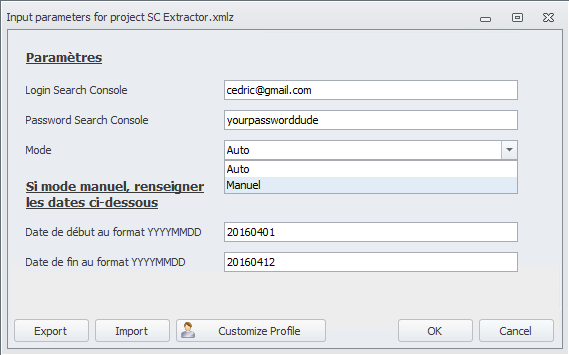

Il vous faut bien sûr une version d’Excel pas trop ancienne si possible. Je n’ai pas testé, mais disons que 2003 est le strict minimum. Ensuite, il y a un outil incontournable en SEO lorsque l’on travaille sur Excel, c’est le plugin SEO Tools for Excel, développé par le Suédois Niels Bosma. Il va donc falloir commencer par installer ce plugin. Pour ce faire, rendez-vous sur cette page http://nielsbosma.se/projects/seotools/download/ et suivez les instructions. Attention, vérifiez bien votre version de Microsoft Excel avant de télécharger le plugin (32-bit ou 64-bit). Inutile de préciser que cette extension est entièrement gratuite, alors même si vous galérez un petit quart d’heure pour l’installer, ne vous en faites pas, ce sera vite rentabilisé.

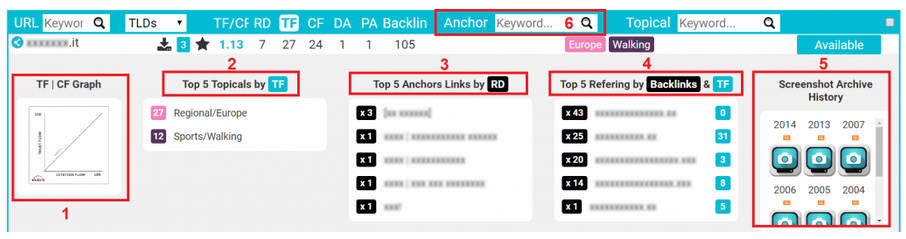

Si vous disposez d’un compte chez Majestic, alors c’est encore mieux. Vous pourrez obtenir les données de Majestic SEO (notamment les Flow Metrics, le nombre de liens entrants et de referers) directement dans Excel. Vous trouverez comment faire sur cette page : Accéder à Majestic SEO dans Excel. Et si vous n’avez pas de compte Majestic SEO, je vous recommande vivement l’offre SILVER à 39,99€ qui sera suffisante.

Ce que vous allez pouvoir faire

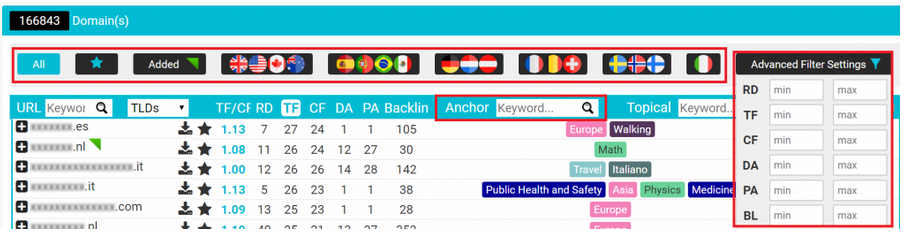

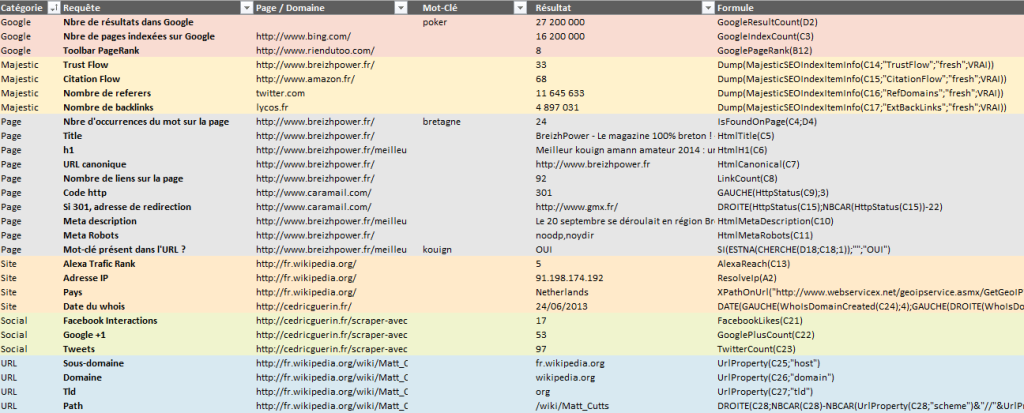

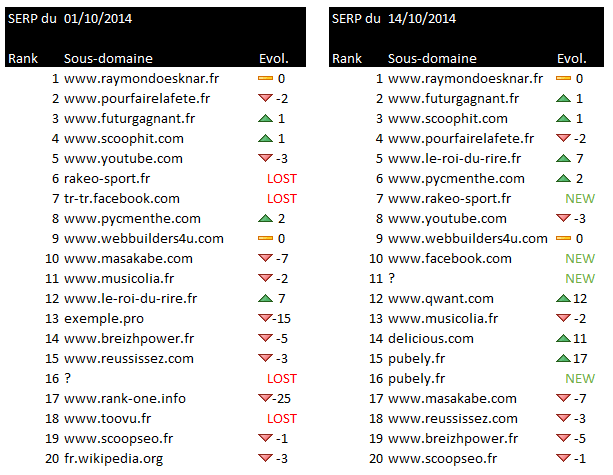

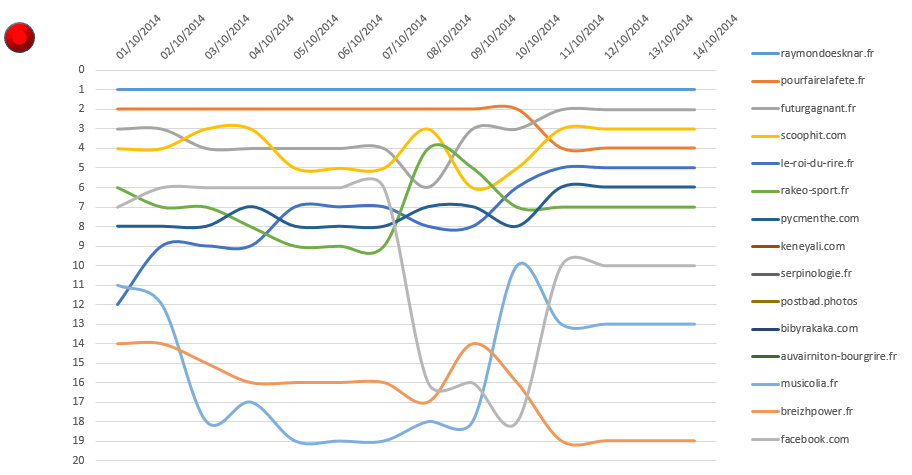

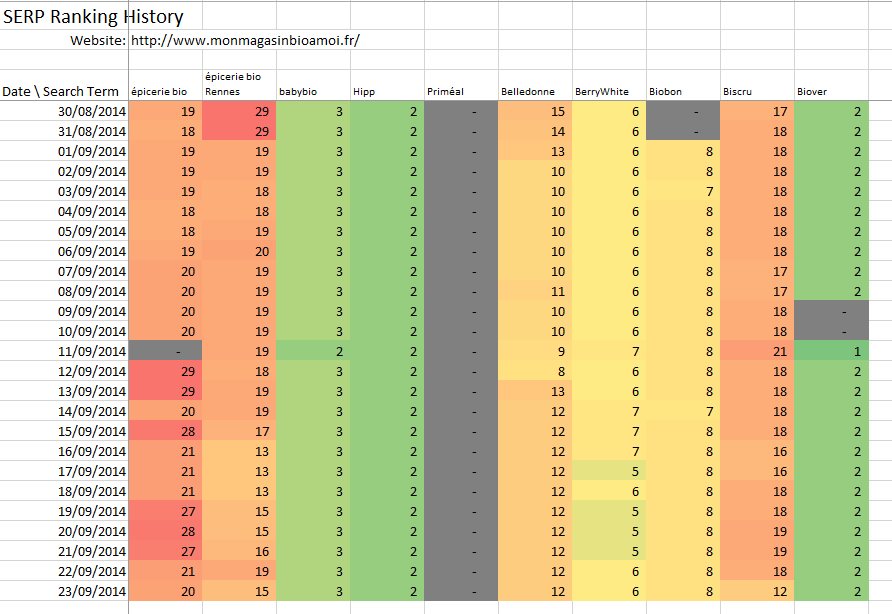

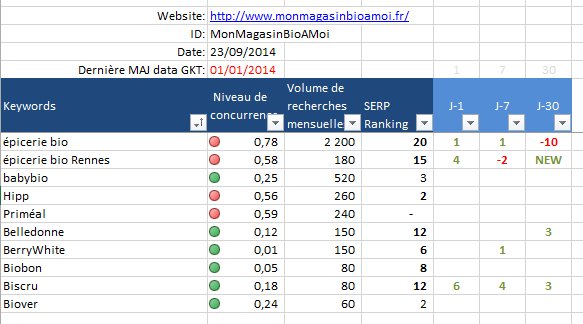

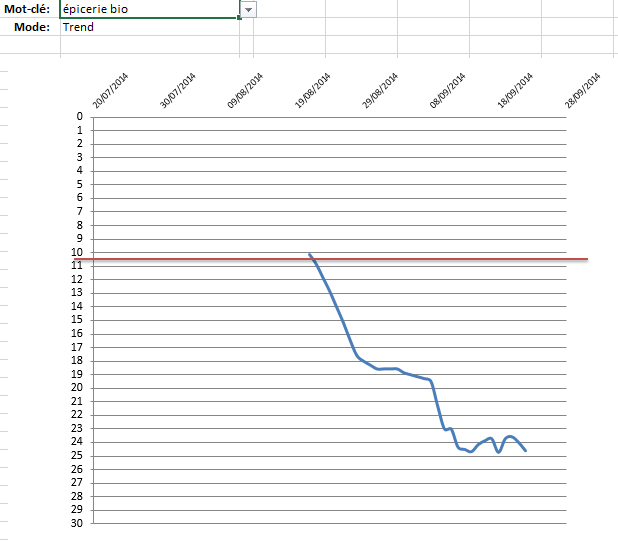

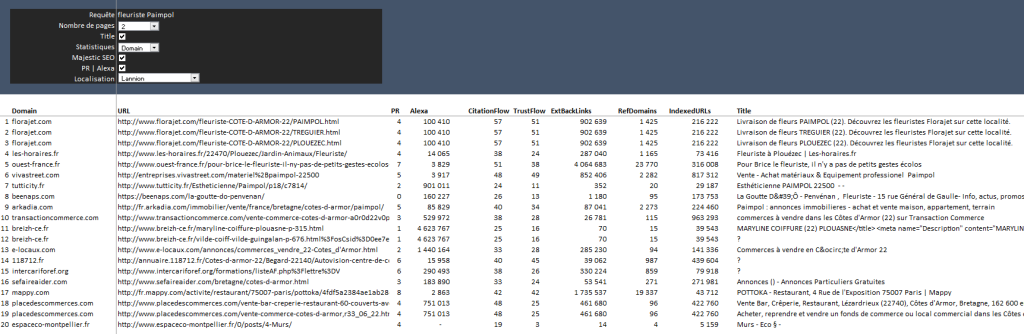

Vous allez pouvoir obtenir la liste des 100 premières URLs et noms de domaines dans les SERPs pour une requête donnée, récupérer le title, le TBPR, l’Alexa Traffic Rank, le nombre de domaines référents, le nombre de backlinks, le nombre d’URLs indexées et les Flow Metrics.

Pour ce faire c’est simple, vous allez :

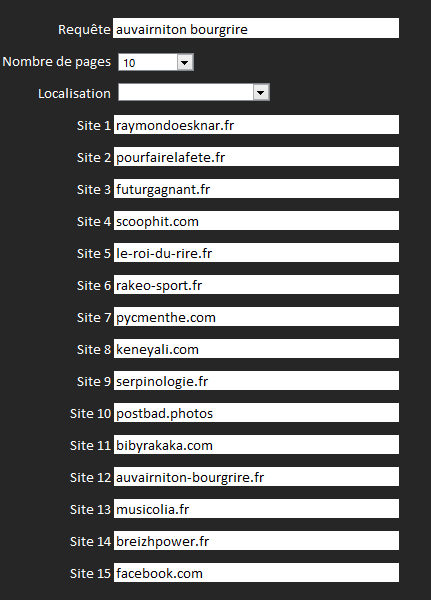

- entrer votre requête (un mot-clé, un footprint)

- sélectionner un nombre de pages à scraper (entre 1 et 10)

- choisir si vous souhaitez récupérer le title

- déterminer si vous souhaitez analyser l’URL ou le domaine racine

- choisir si vous souhaitez afficher les données Majestic SEO (nécessite un compte payant Majestic SEO)

- choisir si vous souhaitez obtenir le TBPR et l’Alexa Traffic Rank

- sélectionner une localité

La prise en compte de la localisation

C’est le petit plus du document. Vous allez pouvoir directement choisir votre localisation et expliquer à votre client qu’il n’est peut-être que 84e sur « fleuriste Paimpol » au niveau national comme lui l’indique son outil de suivi de positionnement, mais qu’il apparaît bien en 2e position lorsque l’internaute est situé à Paimpol, Lannion ou Guingamp (#BreizhPower). Merci à Kévin pour son article Géolocaliser ses SERPs à l’échelle ultra-locale dont je me suis beaucoup servi pour ajouter cette fonctionnalité.

NB : si vous ne souhaitez pas utiliser cette fonctionnalité, remontez en haut de la liste déroulante et laissez le champ vide.

Téléchargez le document

Je vous l’avais promis. Voici le document que j’ai appelé Google Scraper (version 2.1).

Edit 24/09/14 – 10:15 : la version 1.5 contenait un bug, pensez à télécharger la dernière version.

Edit 12/05/16 – 10:00 : la version 2.0 affiche désormais la description présente dans les SERPs.

Edit 06/06/18 – 15:20 : la version 2.1 contient la nouvelle version du connecteur Majestic et ne contient plus les données PR et Alexa.

Quelques consignes au passage :

- Soyez patients, si vous cochez toutes les cases et que vous souhaitez récupérer 10 pages de résultats, ça peut prendre quelques minutes.

- Récupérer les 100 premiers résultats n’est pas toujours utile. Si vous pouvez vous contenter des 20 premiers c’est mieux.

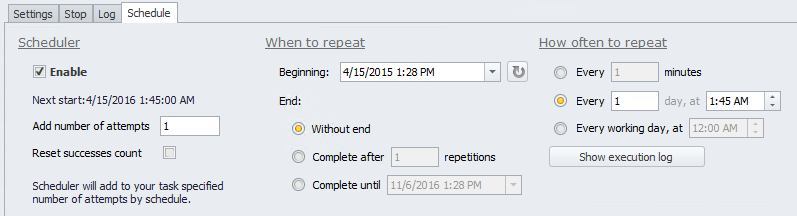

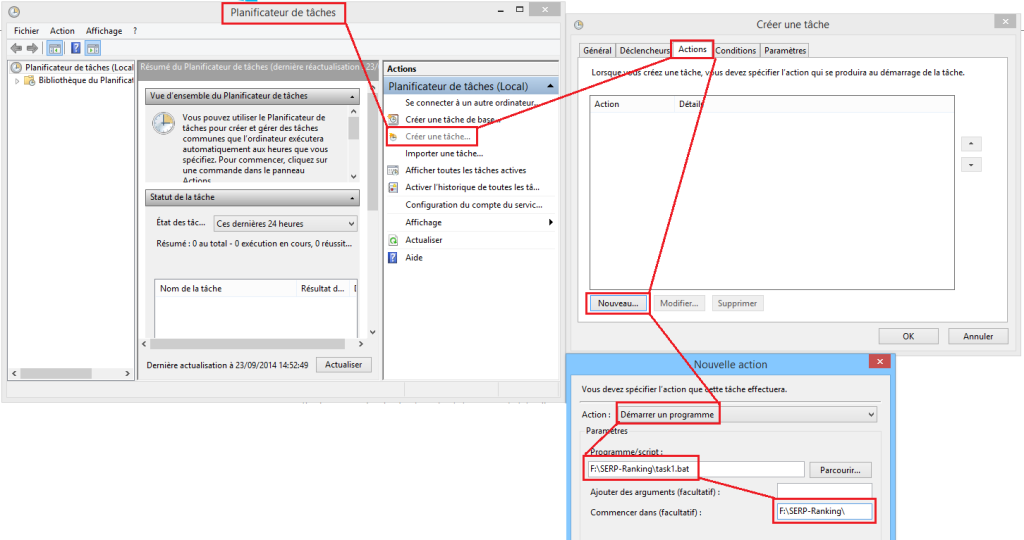

- Un conseil, dans Excel, choisissez de lancer les calculs manuellement (Onglet Formules | Section Options de calcul | Manuel). Et appuyer sur F9 lorsque vous voulez lancer le scrap.

- Ici on scrape sans proxy, donc l’outil n’est pas forcément adapté à une utilisation industrielle, cela dit, vous pouvez bosser sur l’audit concurrentiel de votre client les yeux fermés.

- Pour les initiés, vous pouvez modifier le Xpath en colonne C (attention, il s’agit d’une formule matricielle)

- Edit 24/09/14 – 10:15 : les lignes blanches qui apparaissent parfois correspondent aux résultats Google Image que j’ai pas (encore) réussi à exclure.

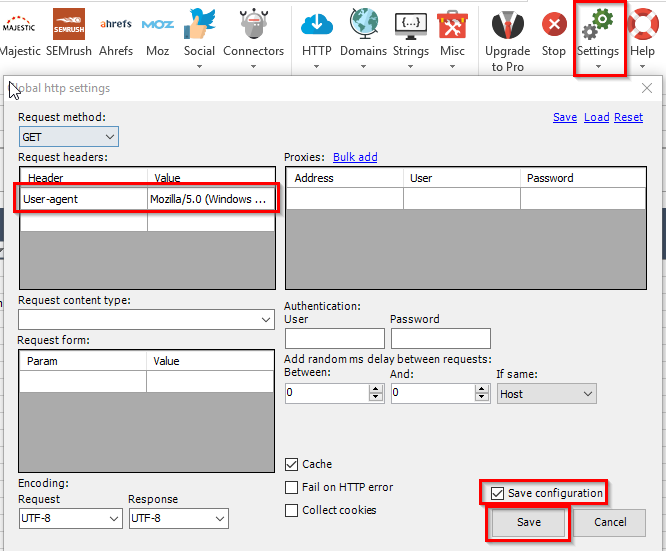

- Edit 25/01/17 – 09:45 : si cela ne fonctionne pas, rendez-vous dans l’onglet Settings de SEO Tools, puis cliquez sur Global HTTP Settings. Dans le premier tableau, renseignez le User-agent suivant : Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 Safari/537.36 puis cochez Save configuration en bas à droite et sauvegardez.